- 23. Februar 2024

- Veröffentlicht durch: Kevin Jilg

- Kategorie: Technologie

Keine Kommentare

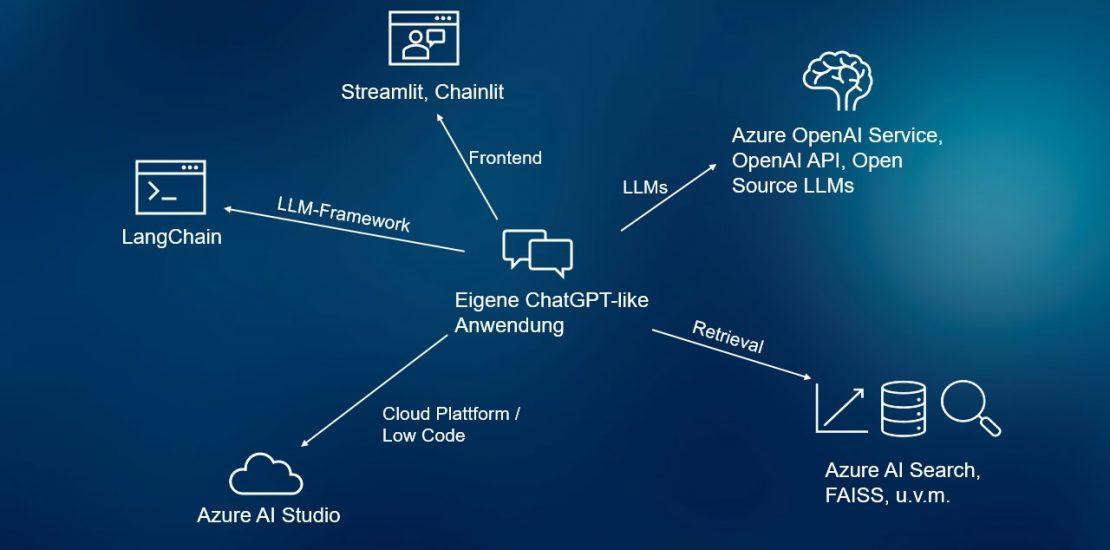

Die Antwort direkt vorneweg: sehr einfach. Dank einer Vielzahl an Bibliotheken und Frameworks insbesondere im Python Ökosystem können selbst komplexe Anforderungen wie die Einbeziehungen eigener Dokumente und Dokumentationen schnell umgesetzt werden. Ich arbeite hierzu hauptsächlich mit folgendem Technologie Stack:

- Programmiersprache: Python

- Frontend Frameworks: Streamlit, Chainlit

- LLM-Framework: LangChain

- LLMs: Azure OpenAI Service API, OpenAI API, Open Source LLMs

- Vektordatenbank / Search Engine / Retriever: Azure AI Search (ehemals Cognitive Search), FAISS, u.v.m.

- Cloud Plattform / Low Code: Azure AI Studio

Daneben gibt es jedoch noch eine Vielzahl weiterer Technologien wie unter anderem:

- LLM-Frameworks: LlamaIndex, Prompt flow, AutoGen

- LLMs: Gemini, PaLM, u.v.m.

- Vektordatenbank / Search Engine / Retriever: Postgres Embedding, PGVector, Pinecone, SAP HANA Cloud Vector Engine, u.v.m.

- No Code Alternative: Copilot Studio (ehemals Power Virtual Agents), OpenAIs Custom GPTs

Für eine detaillierte Übersicht, die Ihre Anforderungen berücksichtigt, nehmen Sie gerne Kontakt auf und ich werde eine persönliche Übersicht für Sie erstellen.