Künstliche Intelligenz

Insbesondere durch die Large Language Models (LLMs) fokussiert sich der Einsatz künstlicher Intelligenz nicht mehr nur auf sehr spitz spezialisierte Anwendungsfälle, sondern ermöglicht breiter einsetzbare Lösungen, die den Namen “persönlicher Assistent” auch wirklich verdienen.

Chatbot auf LLM-Basis

Vor ChatGPT funktionierten Chatbots regelbasiert. Es wurden zuvor definierte Themen erkannt und die entsprechend hinterlegten Abläufe durchgegangen. Das war für die Ersteller aufwendig und für die Nutzer häufig frustrierend. Mit den heute verfügbaren Sprachmodellen sind leistungsfähigere Chatbots mit deutlich weniger Aufwand realisierbar.

Agents

Sie wollen nicht nur einen Chatbot, sondern einen Agenten, der auch selbstständig Aufgaben erledigen kann? Das ist möglich. Von der Auswahl verschiedener Tools und deren Bedienung bis hin zur komplett flexiblen Generierung und Ausführung von Code können Agenten genau mit den Fähigkeiten ausgestattet werden, die zur Aufgabenerfüllung erforderlich sind.

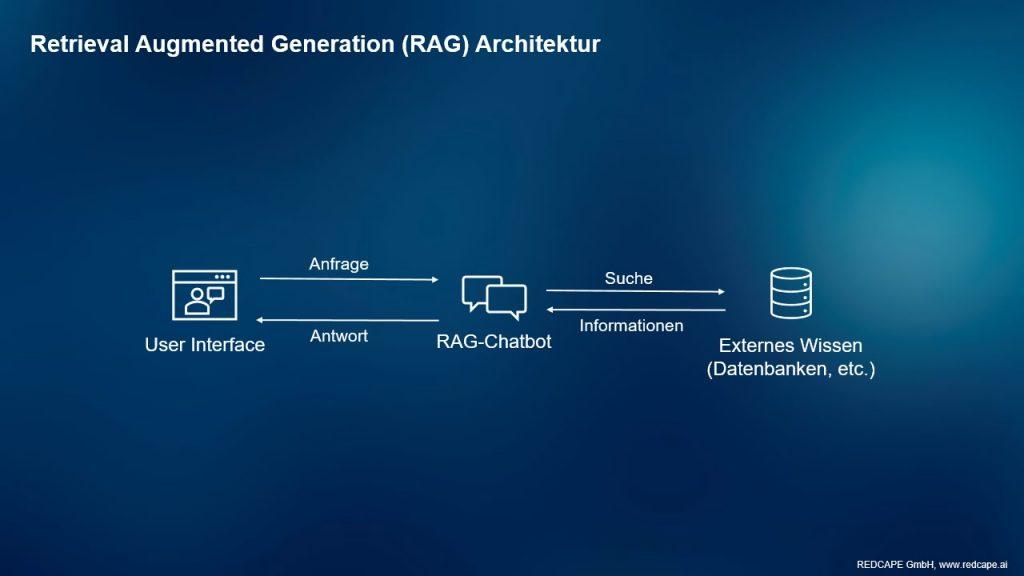

Retrieval Augmented Generation (RAG)

Wie kann ein LLM unternehmensinternes Wissen nutzen, ohne darauf trainiert werden zu müssen? Die Antwort ist eine Retrieval Augmented Generation (kurz RAG) Architektur. Statt direkt die Antwort auf eine Anfrage von einem LLM generieren zu lassen, wird in dieser Architektur zunächst eine Wissensdatenbank nach relevanten Informationen durchsucht und die gefundenen Ergebnisse als Kontext zur Beantwortung der Anfrage vom LLM verwendet. So können auch ohne aufwendiges Training stets aktuelle Informationen berücksichtigt werden und die Quellen können in den Antworten mit angegeben werden.

Multi-Agent Konversationen

Mit steigender Komplexität der Aufgabe sinkt die Qualität der Ergebnisse, die ein einzelnes LLM produzieren kann. Die Lösung ist hier eine Multi-Agent Architektur, bei der mehrere Agents zusammenarbeiten, um eine Aufgabe im Team zu lösen. So kann sich beispielsweise ein “Programmierer-LLM” komplett auf die Generierung von Code fokussieren, während ein “Supervisor-LLM” die Kommunikation mit dem User und die Aufgabenverteilung an die anderen LLMs übernimmt, ein “Quality Manager” kann die Qualität der Ergebnisse und Einhaltung von Vorgaben überwachen, und so weiter. Die Möglichkeiten sind hier endlos.